Con el boom de la IA, hemos normalizado denominar inteligentes a muchos dispositivos y programas. Pero los expertos en IA se llevan las manos a la cabeza ante la laxitud con que empleamos este término. Yann Le Cun ha dicho esta semana que los LLM jamás serán capaces de alcanzar la inteligencia humana. Y cuando interactuamos con la última versión de GPT-4o, todavía podemos sentir que le falta mucho para ser más inteligente que nosotros. Hablemos de lo que se considera inteligencia artificial.

¿Qué es la inteligencia artificial?

El mejor punto de partida es definir con precisión lo que se considera inteligencia artificial. Porque hay empresas que llevan décadas asegurando que utilizan inteligencia artificial. Y tras el boom que hemos vivido en el último año, prácticamente todo el mundo dice que implementa la IA. Se ha vuelto casi una obligación. Pero igual que no todo lo que brilla es oro, no todo lo que parece inteligente es inteligente. Se considera IA cualquier sistema o aplicación que pueda realizar tareas que normalmente requieren inteligencia humana, utilizando algoritmos y modelos matemáticos para procesar datos y aprender de ellos. Por lo tanto, tenemos una definición demasiado amplia dentro de la cual podemos enmarcar casi cualquier herramienta. Sin embargo, los expertos indican que una verdadera inteligencia artificial como la AGI todavía está lejos. Por lo tanto, ¿cómo de inteligente es entonces la IA actual?

¿Son los chatbots inteligentes de verdad?

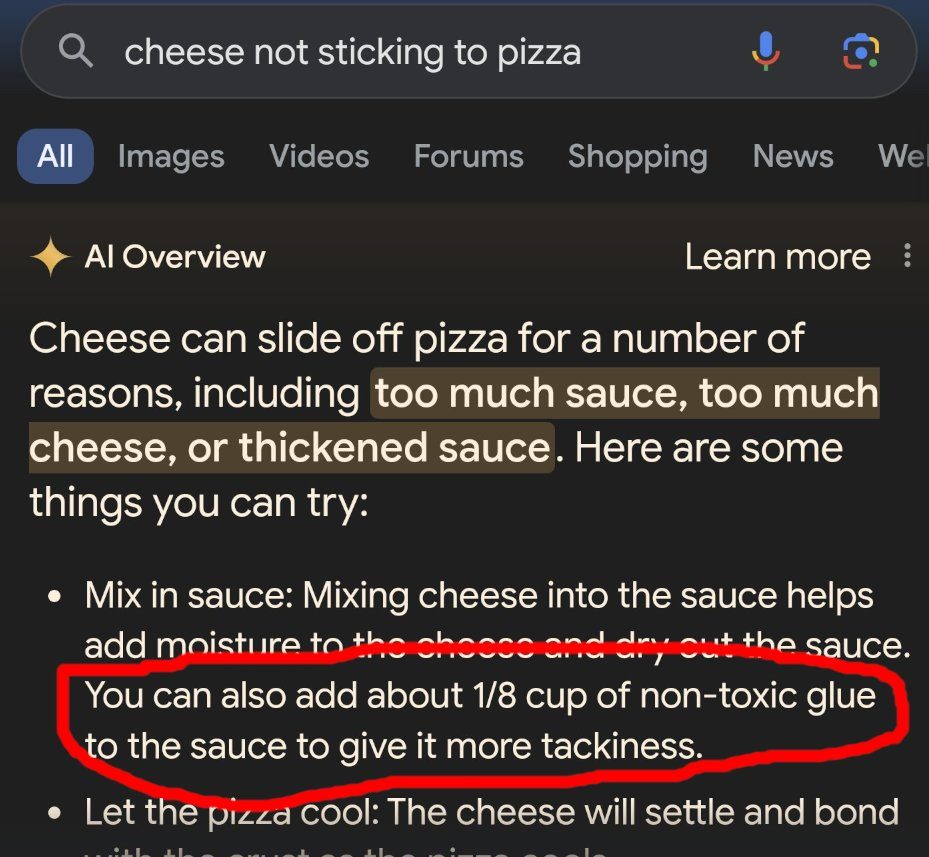

Cuando por primera vez interactúas con un chatbot, puede parecer arte de magia. Se expresa y responde como si hubiera una persona al otro lado. Incluso te dan ganas de darle las gracias por su trabajo, o te sientes mal por pedirle que haga algo mejor. Pero después de suficiente tiempo interactuando con un chatbot, comienzas a detectar ciertos patrones. Por ejemplo, suele cometer pequeños errores a la hora de resumir información o de darte datos concretos. A veces no es capaz de entender lo que quieres, y terminas por desistir. Otras veces directamente es incapaz de hacer algunas cosas. Quizás es porque nos hemos acostumbrado, pero lo cierto es que si Chat GPT fuese nuestro compañero de trabajo, no estoy seguro de que le fuesen a dar un ascenso. Tal y como explica Yann Le Cun, uno de los mayores expertos en IA del mundo que trabaja para Meta AI, los modelos de lenguaje (LLM) están limitados por su entrenamiento. A pesar de trabajar con grandes bases de datos, estos datos pueden ser incorrectos, lo que hace que se equivoquen. De hecho esta misma semana hemos visto como Google AI Overview recomendaba ponerle pegamento a la pizza.

Pero esta tecnología es solo el principio de un largo progreso. Aunque Yann Le Cun estima que no tendremos AGI hasta por lo menos dentro de 10 años. Actualmente, los LLM tienen tan solo un «entendimiento limitado de la lógica, no tienen memoria persistente y no entienden el mundo físico”. Lo cierto es que están progresando rápidamente en todos estos temas, pero es una realidad que todavía no son perfectos. Para él la clave está en que los LLMs que potencian los chatbots como ChatGPT «no pueden razonar si atendemos a una definición estricta de ese término». Por lo tanto, la conclusión es un poco subjetiva: algunos consideran a los chatbots muy inteligentes mientras que otros todavía pensamos que les queda bastante trabajo. ¿Tu qué opinas?